GPU 的历史性时刻!

2023-08-28 18:25:37 | 来源:半导体行业观察 |

2023-08-28 18:25:37 | 来源:半导体行业观察 |

8 月 23 日,GPU 巨头 Nvidia 发布了 2023 年二季度财报,其结果远超预期。总体来说,Nvidia 二季度的收入达到了 135 亿美元,相比去年同期增长了 101%;净利润达到了 61 亿美元,相比去年同期增长了 843%。Nvidia 公布的这一惊人的财报一度在盘后让 Nvidia 股票大涨 6%,甚至还带动了众多人工智能相关的科技股票在盘后跟涨。

【资料图】

【资料图】

Nvidia 收入在二季度如此大涨,主要靠的就是目前方兴未艾的人工智能风潮。ChatGPT 为代表的大模型技术从去年第三季度以来,正在得到全球几乎所有互联网公司的追捧,包括美国硅谷的谷歌、亚马逊以及中国的百度、腾讯、阿里巴巴等等巨头。而这些大模型能进行训练和推理的背后,都离不开人工智能加速芯片,Nvidia 的 GPU 则是大模型训练和推理加速目前的首选方案。由于个大科技巨头以及初创公司都在大规模购买 Nvidia 的 A 系列和 H 系列高端 GPU 用于支持大模型训练算力,这也造成了 Nvidia 的数据中心 GPU 供不应求,当然这反映到财报中就是收入和净利润的惊人增长。

事实上,从 Nvidia 的财报中,除了亮眼的收入和净利润数字之外,还有一个关键的数字值得我们关注,就是 Nvidia 二季度的数据中心业务收入。根据财报,Nvidia 二季度的数据中心业务收入超过了 100 亿美元,相比去年同期增长 171%。Nvidia 数据中心业务数字本身固然非常惊人,但是如果联系到其他公司的同期相关收入并进行对比,我们可以看到这个数字背后更深远的意义。同样在 2023 年第二季度,Intel 的数据中心业务收入是 40 亿美元,相比去年同期下降 15%;AMD 的数据中心业务收入是 13 亿美元,相比去年同期下降 11%。我们从中可以看到,在数据中心业务的收入数字上,Nvidia 在 2023 年第二季度的收入已经超过了 Intel 和 AMD 在相同市场收入的总和。

这样的对比的背后,体现出了在人工智能时代,人工智能加速芯片(GPU)和通用处理器芯片(CPU)地位的反转。目前,在数据中心,人工智能加速芯片 /GPU 事实上最主流的供货商就是 Nvidia,而通用处理器芯片 /CPU 的两大供货商就是 Intel 和 AMD,因此比较 Nvidia 和 Intel+AMD 在数据中心领域的收入数字就相当于比较 GPU 和 CPU 之间的出货规模。虽然人工智能从 2016 年就开始火热,但是在数据中心,人工智能相关的芯片和通用芯片 CPU 相比,获得的市场份额增长并不是一蹴而就的:在 2023 年之前,数据中心 CPU 的份额一直要远高于 GPU 的份额;甚至在 2023 年第一季度,Nvidia 在数据中心业务上的收入(42 亿美元)仍然要低于 Intel 和 AMD 在数据中心业务的收入总和;而在第二季度,这样的力量对比反转了,在数据中心 GPU 的收入一举超过了 CPU 的收入。

这也是一个历史性的时刻。从上世纪 90 年代 PC 时代开始,CPU 一直是摩尔定律的领军者,其辉煌从个人电脑时代延续到了云端数据中心时代,同时也推动了半导体领域的持续发展;而在 2023 年,随着人工智能对于整个高科技行业和人类社会的影响,用于通用计算的 CPU 在半导体芯片领域的地位正在让位于用于人工智能加速的 GPU(以及其他相关的人工智能加速芯片)。

摩尔定律的故事在 GPU 上仍然在发生

众所周知,CPU 的腾飞离不开半导体摩尔定律。根据摩尔定律,半导体工艺特征尺寸每 18 个月演进一代,同时晶体管的性能也得大幅提升,这就让 CPU 在摩尔定律的黄金时代(上世纪 80 年代至本世纪第一个十年)突飞猛进:一方面 CPU 性能每一年半就迭代一次,推动新的应用出现,另一方面新的应用出现又进一步推动对于 CPU 性能的需求,这样两者就形成了一个正循环。这样的正循环一直到 2010 年代,随着摩尔定律逐渐接近物理瓶颈而慢慢消失——我们可以看到,最近 10 年中,CPU 性能增长已经从上世纪 8、90 年代的 15% 年复合增长率(即性能每 18 个月翻倍)到了 2015 年后的 3% 年复合增长率(即性能需要 20 年才翻倍)。

但是,摩尔定律对于半导体晶体管性能增长的驱动虽然已经消失,但是摩尔定律所预言的性能指数级增长并没有消失,而是从 CPU 转到了 GPU 上。如果我们看 2005 年之后 GPU 的性能(算力)增长,我们会发现它事实上一直遵循了指数增长规律,大约 2.2 年性能就会翻倍!

同样是芯片,为什么 GPU 能延续指数级增长?这里,我们可以从需求和技术支撑两方面来分析:需求意味着市场上是不是有应用对于 GPU 的性能指数级增长有强大的需求?而技术支撑则是,从技术上有没有可能实现指数级性能增长?

从需求上来说,人工智能确实存在着这样强烈需求。我们可以看到,从 2012 年(神经网络人工智能复兴怨念开始)到至今,人工智能模型的算力需求确实在指数级增长。2012 年到 2018 年是卷积神经网络最流行的年份,在这段时间里我们看到人工智能模型的算力需求增长大约是每两年 15 倍。在那个时候,GPU 主要负责的是模型训练,而在推理部分 GPU 的性能一般都是绰绰有余。而从 2018 年进入以 Transformer 架构为代表的大模型时代后,人工智能模型对于算力需求的演进速度大幅提升,已经到了每两年 750 倍的地步。在大模型时代,即使是模型的推理也离不开 GPU,甚至单个 GPU 都未必能满足推理的需求;而训练更是需要数百块 GPU 才能在合理的时间内完成。这样的性能需求增长速度事实上让 GPU 大约每两年性能翻倍的速度都相形见拙,事实上目前 GPU 性能提升速度还是供不应求!因此,如果从需求侧去看,GPU 性能指数级增长的曲线预计还会延续很长一段时间,在未来十年内 GPU 很可能会从 CPU 那边接过摩尔定律的旗帜,把性能指数级增长的神话续写下去。

GPU 性能指数增长背后的技术支撑

除了需求侧之外,为了能让 GPU 性能真正维持指数增长,背后必须有相应的芯片技术支撑。我们认为,在未来几年内,有三项技术将会是 GPU 性能维持指数级增长背后的关键。

第一个技术就是领域专用(domain-specific)芯片设计。同样是芯片,GPU 性能可以指数级增长而 CPU 却做不到,其中的一个重要因素就是 GPU 性能增长不仅仅来自于晶体管性能提升和电路设计改进,更来自于使用领域专用设计的思路。例如,在 2016 年之前,GPU 支持的计算主要是 32 位浮点数(fp32),这也是在高性能计算领域的默认数制;但是在人工智能兴起之后,研究表明人工智能并不需要 32 位浮点数怎么高的精度,而事实上 16 位浮点数已经足够用于训练,而推理使用 8 位整数甚至 4 位整数都够了。而由于低精度计算的开销比较小,因此使用领域专用计算的设计思路,为这样的低精度计算做专用优化可以以较小的代价就实现人工智能领域较大的性能提升。从 Nvidia GPU 的设计我们可以看到这样的思路,我们看到了计算数制方面在过去的 10 年中从 fp32 到 fp16 到 int8 和 int4 的高效支持,可以说是一种低成本快速提高性能的思路。除此之外,还有对于神经网络的支持(TensorCore),稀疏计算的支持,以及 Transformer 的硬件支持等等,这些都是领域专用设计在 GPU 上的很好体现。在未来,GPU 性能的提升中,可能是有很大一部分来自于这样的领域专用设计,往往一两个专用加速模块的引入就能打破最新人工智能模型的运行瓶颈来大大提升整体性能,从而实现四两拨千斤的效果。

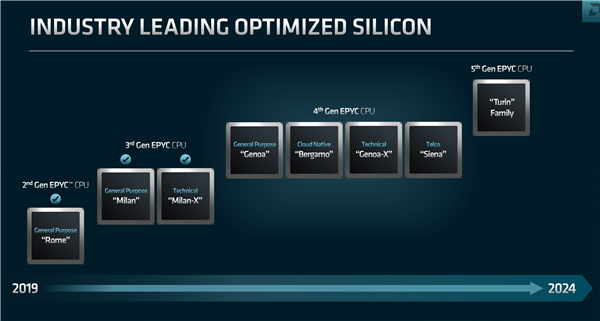

第二个技术就是高级封装技术。高级封装技术对于 GPU 的影响来自两部分:高速内存和更高的集成度。在大模型时代,随着模型参数量的进一步提升,内存访问性能对于 GPU 整体性能的影响越来越重要——即使 GPU 芯片本身性能极强,但是内存访问速度不跟上的话,整体性能还是会被内存访问带宽所限制,换句话说就是会遇到 " 内存墙 " 问题。为了避免内存访问限制整体性能,高级封装是必不可少的,目前的高带宽内存访问接口(例如已经在数据中心 GPU 上广泛使用的 HBM 内存接口)就是一种针对高级封装的标准,而在未来我们预期看到高级封装在内存接口方面起到越来越重要的作用,从而助推 GPU 性能的进一步提升。高级封装对于 GPU 性能提升的另一方面来自于更高的集成度。最尖端半导体工艺(例如 3nm 和以下)中,随着芯片规模变大,芯片良率会遇到挑战,而 GPU 可望是未来芯片规模提升最激进的芯片品类。在这种情况下,使用芯片粒将一块大芯片分割成多个小芯片粒,并且使用高级封装技术集成到一起,将会是 GPU 突破芯片规模限制的重要方式之一。目前,AMD 的数据中心 GPU 已经使用上了芯片粒高级封装技术,而 Nvidia 预计在不久的未来也会引入这项技术来进一步继续提升 GPU 芯片集成度。

最后,高速数据互联技术将会进一步确保 GPU 分布式计算性能提升。如前所述,大模型的算力需求提升速度是每两年 750 倍,远超 GPU 摩尔定律提升性能的速度。这样,单一 GPU 性能赶不上模型算力需求,那么就必须用数量来凑,即把模型分到多块 GPU 上进行分布式计算。未来几年我们可望会看到大模型使用越来越激进的分布式计算策略,使用数百块,上千块甚至上万块 GPU 来完成训练。在这样的大规模分布式计算中,高速数据互联将会成为关键,否则不同计算单元之间的数据交换将会成为整体计算的瓶颈。这些数据互联包括近距离的基于电气互联的 SerDes 技术:例如在 Nvidia 的 Grace Hopper Superchip 中,使用 NVLINK C2C 做数据互联,该互联可以提供高达 900GB/s 的数据互联带宽(相当于 x16 PCIe Gen5 的 7 倍)。另一方面,基于光互联的长距离数据互联也会成为另一个核心技术,当分布式计算需要使用成千上万个计算节点的时候,这样的长距离数据交换也会变得很常见并且可能会成为系统性能的决定性因素之一。

我们认为,在人工智能火热的年代,GPU 将会进一步延续摩尔定律的故事,让性能指数级发展继续下去。为了满足人工智能模型对于性能强烈的需求,GPU 将会使用领域专用设计、高级封装和高速数据互联等核心技术来维持性能的快速提升,而 GPU 以及它所在的人工智能加速芯片也将会成为半导体领域技术和市场进步的主要推动力。

* 免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。

关键词: